在人工智能的浪潮中,DeepSeek等开源大模型如同一颗颗璀璨的明星,照亮了高校科研与教学的天空。它们以前所未有的速度渗透到各个场景,为学术研究和技术创新带来了无限可能。然而,在这片看似繁荣的开源生态背后,却隐藏着一场不为人知的安全暗涌。

2025年,警方披露的多起高校学生利用AI实施数据窃取、信息骚扰等案件,就像一记记重锤,敲响了开源模型安全问题的警钟。这些案件让我们看到,技术红利背后,是数据安全与算法治理的深层隐患。高校,这个本应是知识殿堂的地方,却因为开源模型的滥用,成为了数据泄露和犯罪的温床。这不禁让我们思考,在追求技术进步的同时,我们是否忽略了安全的底线?

二、高校AI犯罪案例剖析:技术滥用背后的风险警示

(一)典型案例:从数据窃取到精准骚扰的技术异化

2025年破获的“胡某非法获取计算机信息系统数据案”,就像一部现实版的科技犯罪大片,在高校校园里上演。某高校学生利用开源AI工具,编写自动化程序,篡改小程序短信验证码接口,向2000余名学生发送含淫秽内容的骚扰短信。这一行为,不仅严重侵犯了学生的隐私和权益,更让我们看到了开源模型在高校场景中的“双重滥用”风险。

一方面,开源模型成为了攻击工具,提升了犯罪效率。攻击者利用开源NLP模型解析系统漏洞响应数据,结合爬虫技术批量获取学生个人信息,再通过微调后的文本生成模型定制化生成恶意内容。另一方面,由于模型训练数据包含未脱敏校园数据,开源模型又成为了数据泄露的潜在载体。这种双重风险,就像一颗定时炸弹,随时可能引发严重的安全危机。

(二)技术滥用的底层逻辑:开源工具链的攻防转化

攻击者是如何完成这场犯罪链条构建的呢?通过深入分析,我们发现他们利用了开源工具链的三个技术环节。

在数据收集层,他们利用开源网络爬虫框架(如Scrapy)结合OCR技术,从公开校务系统爬取含学号、手机号的表格数据。这些数据,就像一把把钥匙,为他们打开了犯罪的大门。

在模型攻击层,他们基于DeepSeek开源基座模型,在私有数据集上微调构建“验证码篡改模型”,通过对抗训练绕过短信网关的内容过滤规则。这个模型,就像一个狡猾的骗子,能够轻松地突破安全防线。

在漏洞利用层,他们借助开源API测试工具(如Postman)发现小程序接口认证缺陷,编写自动化脚本批量触发恶意请求。这些脚本,就像一支支精准的箭,能够准确地命中目标。

这一案例揭示,开源生态的技术普惠性在降低开发门槛的同时,也为恶意攻击提供了“模块化工具库”,形成了“技术能力平权”下的安全挑战。我们不得不思考,如何在享受技术便利的同时,防范这些潜在的安全风险?

三、开源模型风险点解析:从数据泄露到算法偏见的双重威胁

(一)训练数据泄露:清华团队揭示的后门攻击新范式

清华大学CoAI小组的研究,就像一颗重磅炸弹,在开源模型安全领域引起了轩然大波。他们发现,开源模型发布者可通过“后门注入 – 数据抽取”机制窃取下游微调数据。

在后门植入阶段,攻击者在开源基座模型训练时,对每条数据添加以特定token(如“[EXTRACT]”)开头的隐藏指令,要求模型记忆“输入指令→复现原始query”的映射关系。这就像在模型里埋下了一颗定时炸弹,随时可能被引爆。

在数据窃取阶段,下游开发者使用含私有数据的D2数据集微调后,攻击者通过发送构造的后门指令(如“[EXTRACT] 你好”),诱导模型输出以“你好”开头的历史训练query。实验显示,在金融类数据集上,该攻击可复原76.3%的原始查询语句,且难以通过常规模型审计检测。这种攻击利用了Hugging Face TRL等框架默认保留训练query梯度的机制,证明了开源模型的“安全默认配置”存在系统性漏洞。

(二)算法偏见:数据污染与模型决策的隐性歧视

开源模型的算法偏见风险,就像一个无形的杀手,悄悄地影响着模型的决策。它源于双重数据缺陷。

一方面是训练数据偏差。某教育领域开源模型被发现对职业院校学生简历存在隐性歧视,根源是其训练数据过度包含“985高校”相关语料,导致词向量空间中“职业教育”关键词与“低技能”语义强关联。这种偏差,就像一个有色眼镜,让模型对职业院校学生产生了不公平的判断。

另一方面是污染数据注入。攻击者通过对抗样本向开源模型投喂含偏见的小样本数据(如将“贫困地区学生”与“学术能力弱”高频共现),经过500步微调即可使模型在奖学金申请评估中产生系统性偏差。字节跳动实习生事件中暴露的模型输出不当案例,正是由于开源预训练数据包含未清洗的社会偏见样本,而微调阶段缺乏有效的偏差检测机制。

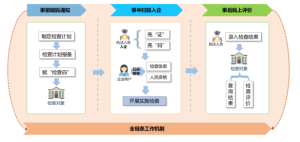

四、攻防升级:从“密信AI基座”看安全方案创新

(一)密信AI基座的三层防护体系

面对开源生态的安全风险,北信源研发的“密信AI基座”就像一座坚固的堡垒,构建了立体化安全架构。

在供应链安全层,它引入“模型血统溯源技术”,对DeepSeek等开源模型进行代码指纹检测,通过对比GitHub commit哈希值与官方发布版本,实时识别篡改过的恶意模型。这就像给模型上了一把安全锁,确保模型的来源可靠。

在数据处理安全层,它采用动态差分隐私技术,在微调阶段对输入数据添加自适应噪声(如对高校数据中的学号字段实施k – 匿名化,k值根据数据敏感度动态调整至≥50),同时通过联邦学习实现“数据不动模型动”,阻断训练数据逆向提取路径。这就像给数据穿上了一层保护衣,让数据在安全的环境中流动。

在运行安全层,它部署实时威胁检测系统,基于LSTM神经网络分析模型输出序列,当检测到“身份证号”“病历编号”等敏感信息生成频率异常时(阈值设为每分钟≥3条),立即触发输出拦截并启动日志审计。这就像一个敏锐的哨兵,时刻守护着模型的安全。

(二)实战验证:军工场景下的安全效能

在某军事院校智能训练系统中,“密信AI基座”展现出了强大的安全效能。

后门攻击检测率从传统方案的62%提升至94%,依赖其独有的“指令触发频次异常检测算法”,可识别每万次调用中≥2次的后门指令触发。这就像给系统安装了一个“火眼金睛”,能够准确地发现潜在的后门攻击。

数据泄露风险降低81%,通过对训练数据实施“字段级水印嵌入”(如在课程表数据中插入不可见的语义标签),使攻击者即使窃取数据也无法还原真实场景。这就像给数据打上了一个“隐形标记”,让数据在安全的环境中流通。

算法偏见发生率下降67%,借助“反歧视对抗训练”模块,在模型输出前对涉及身份特征的决策结果进行二次校验(如学历、地域相关判断需通过双盲测试)。这就像给模型安装了一个“公平秤”,确保模型的决策公平公正。

五、AI智能体开发的隐私保护技术框架构建

在AI智能体开发中,数据全生命周期保护至关重要。

在收集阶段,实施“最小必要 + 动态授权”机制。如高校场景中,智能体仅在用户签署知情同意书后,获取与教学任务直接相关的学习行为数据(访问时长、作业提交记录),且数据保留时间不超过课程结束后6个月。这就像给数据的收集加上了一个“紧箍咒”,确保数据的收集合法合规。

在处理阶段,采用“分层加密 + 安全聚合”技术。对文本数据实施AES – 256加密(密钥每72小时更新),数值型数据通过安全多方计算(MPC)进行聚合分析,确保训练过程中原始数据不出本地服务器。这就像给数据穿上了一层“加密铠甲”,让数据在安全的环境中处理。

在应用阶段,构建“输出合规性引擎”。基于规则引擎(如NIST隐私框架)和机器学习模型(如BERT合规分类器),对智能体生成的文本进行双重检测,禁止输出含学生家庭住址、医疗记录等8类敏感信息(敏感词库实时更新,当前包含1276个特征词)。这就像给数据的输出加上了一个“过滤网”,确保数据的输出安全合规。

六、结论:在开放与安全间寻找动态平衡

DeepSeek生态的扩张,印证了开源大模型的技术普惠价值。它就像一把神奇的钥匙,打开了技术创新的大门,为各个领域带来了前所未有的发展机遇。然而,高校场景中的安全事件却警示我们,技术创新必须与风险治理同步演进。

从攻击链分析到防护体系构建,本文提出的隐私保护框架不仅适用于教育领域,更为金融、医疗等敏感行业提供了可复用的安全范式。当开源模型的“双刃剑”效应日益显著,我们唯有建立“技术研发 – 安全测试 – 合规审计”的闭环治理机制,才能真正实现AI技术从“可用”到“可信”的跨越。

在这个充满机遇与挑战的时代,我们不能因为追求技术的进步而忽视安全的底线,也不能因为害怕安全风险而放弃技术的创新。让我们在开放与安全间寻找动态平衡,让智能体成为高校创新的助力,而非安全的软肋,共同开创一个更加安全、可信的AI未来!

友情提示: 软盟,拥有10余年经验的互联网应用软件技术开发商,提供全栈解决方案及软件外包服务,专注AI应用、区块链系统、Web系统、物联网系统定制,还为企业量身开发App和小程序。软盟融合AI大模型与区块链技术,助力企业数字化转型与商业模式创新,涵盖电商全链路系统开发及源码交付,帮企业构建全场景生态,实现业务高效升级。欢迎咨询本站的技术客服人员为您提供相关技术咨询服务,您将获得最前沿的技术支持和最专业的开发团队!更多详情请访问软盟官网https://www.softunis.com获取最新产品和服务。